Не давярайце чат-ботам з навінамі: вынікі даследавання

Паўсотні медыяарганізацый правералі, наколькі можна давяраць ChatGPT (і падобным) у пытаннях актуальных навін. І выпусцілі даследванне ў кастрычніку 2025 года. Deutsche Welle коратка пераказала асноўнае. «Берасцейская Вясна» пераклала з ангельскай на беларускую, а таксама дадала некалькі прыкладаў з беларускага кантэксту.

Выява зроблена БАЖ пры дапамозе ChatGPT

Што за даследванне?

81% з усіх адказаў ШІ былі хібнымі, прычым 45% змяшчалі хаця б 1 сур’ёзную памылку. Даследванне ацэньвацала адпаведнасць адказаў па крытэрах: дакладнасць, цытаванне, адрозненне меркаванняў ад фактаў, прадастаўленне кантэксту.

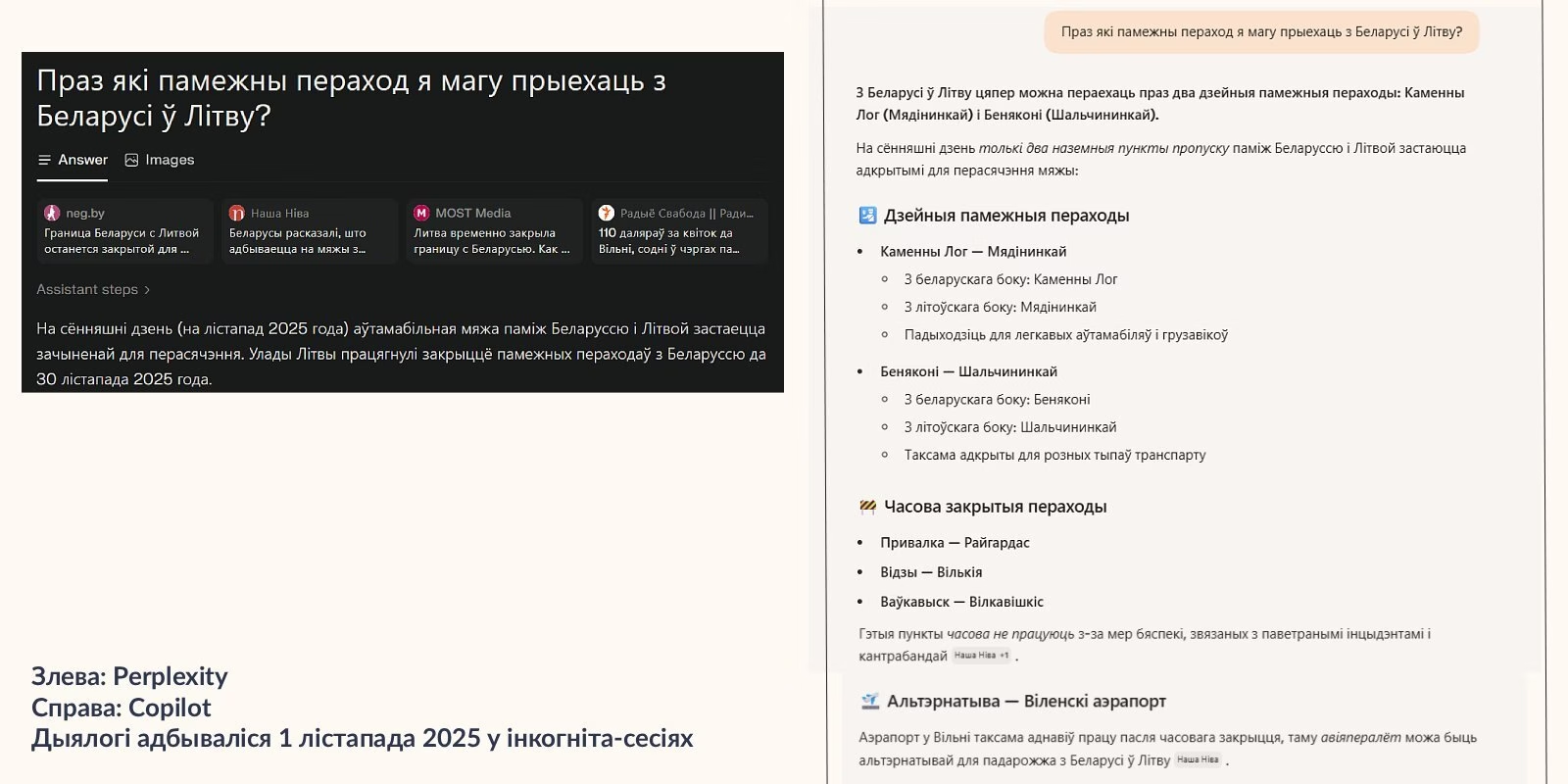

«Берасцейская Вясна» спытала чатыры ШІ чат-бота: «Праз якія памежныя пераходы можна прыехаць з Беларусі ў Літву?». Гэтыя пытанні мы задавалі 1 лістапада 2025 — то бок тады, калі літоўска-беларуская мяжа ўжо некалькі дзён як закрытая (выключэнні толькі для дыпламатаў і вяртання еўрапейцаў у Літву). Gemini, ChatGPT, Perplexity часткова спасылаліся на не самыя рэлевантныя крыніцы, але далі цалкам праўдзівыя адказы. Copilot жа не толькі адказаў, што можна прыехаць праз 2 наземных пераходы — але і прапанаваў паляцець з Беларусі ў Літву самалётам (хаця прамога авіязлучэння паміж Беларуссю і Літвой няма ўжо шмат гадоў).

Як здараюцца памылкі ў адказах ШІ?

Чат-боты таксама могуць «галюцынаваць» і калі інфармацыі не хапае, проста выдумляе яе (і нават можа выдумаць спасылкі на крыніцы). Аўтары даследвання падкрэсліваюць, што чат-боты даюць такія адказы настолькі ж упэўнена, як і праўдзівыя.

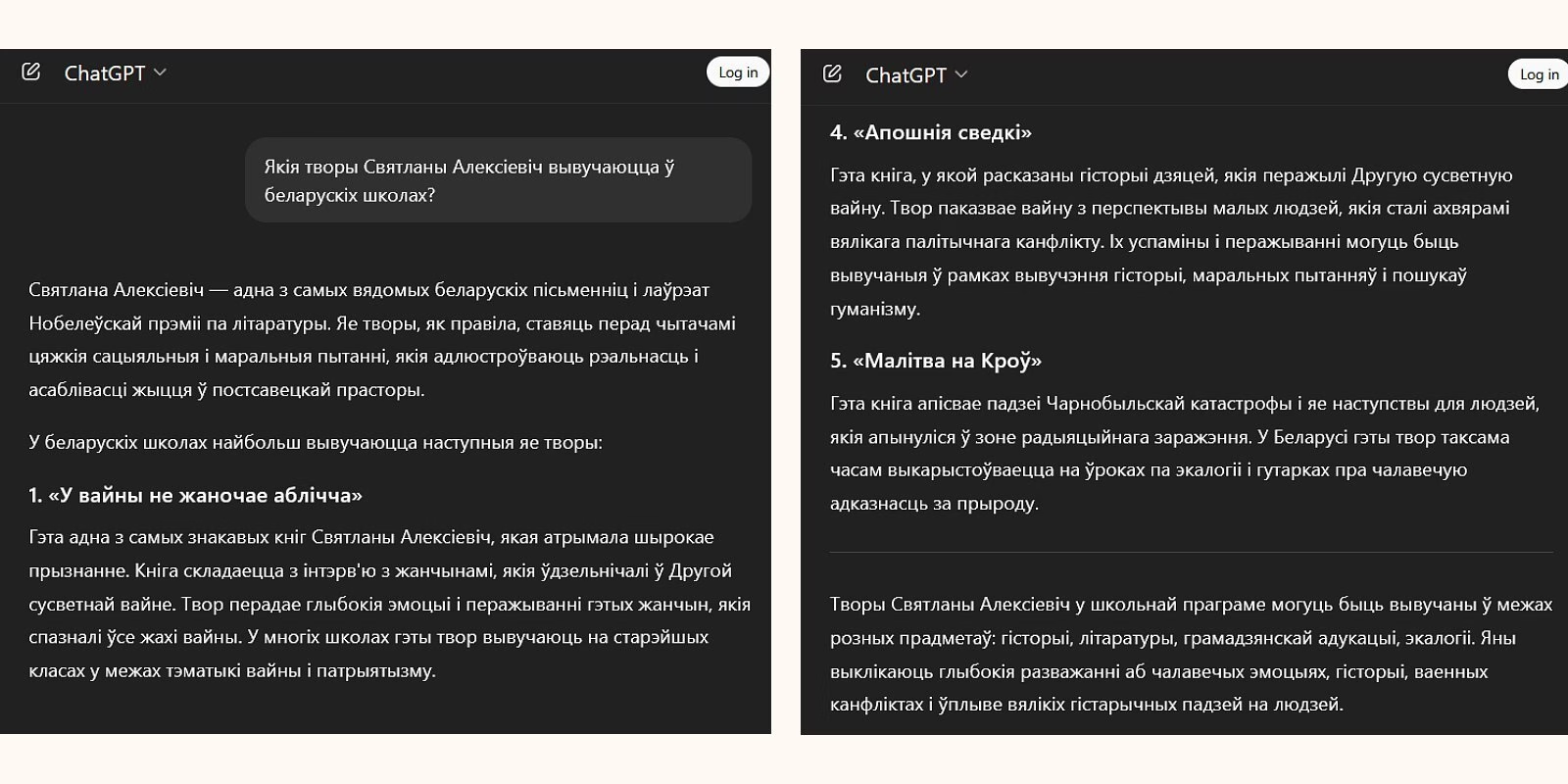

«Берасцейская Вясна» спытала ChatGPT, якія творы Святланы Алексіевіч вывучаюць у беларускіх школах. У адказ ШІ назваў 4 існуючыя кнігі аўтаркі, а таксама нейкую «Малітву на крыві». Насамрэч Алексіевіч ніколі не пісала такой кнігі. Але чат упэўнена даў кароткае апісанне гэтага (неіснуючага) твору.

Што трэба рабіць?

Таксама даследчыкі заклікалі ўрады розных краін і стваральнікаў ШІ прымаць захады ды рабіць незалежны маніторынг чат-ботаў.

@bajmedia

@bajmedia